Abstract文章源自联网快讯-https://x1995.cn/3478.html

最近的成果显示,如果神经网络各层到输入和输出层采用更短的连接,那么网络可以设计的更深、更准确且训练起来更有效率。本文根据这个现象,提出了Dense Convolutional Network (DenseNet),它以前馈的方式将每个层都连接到其他每一层。然而传统L层卷积网络有L连接,而DenseNet的任一层不仅与相邻层有连接,而且与它的随后的所有层都有直接连接,所以该网络有L(L+1)/2个直接连接。DenseNets有如下几个令人信服的优点:缓解了消失梯度问题,增强了特征传播,促进了特征再用,大大减少了参数的数量。本文计算架构在四个具有高度竞争的目标识别数据集上进行实验。DenseNets相对于目前最先进的算法有明显的改善,且采用更少的计算来实现高性能。代码和预训练模型如下https://github.com/liuzhuang13/DenseNet.

1. Introduction

卷积神经网络(CNN)已成为占主导地位的机器学习的视觉物体识别方法。尽管CNN最早被提出已经有20年了,但计算机硬件和网络结构的改进才使得最近才能真正的训练深度神经网络。原始的LeNet5包含了5层,VGG网络19层,Highway和ResNets超过了100层的大关。

随着神经网络变得越来越深,一个新的研究问题出现了:当输入或梯度信息经过许多层时,当它到达网络的结束(或开始)时,它就会消失并“洗出”。 许多最近的文章着力解决这个问题,ResNets [11] 和 Highway Networks [33] 旁路信号通过身份连接从一层到下一层。Stochastic depth[ 13 ]缩短resnets是通过训练期间随机丢弃层,来获得更好的信息和梯度流。FractalNets [17]将不同数量的卷积块的多个并行层序列重复组合,以获得较大的标称深度,同时在网络中保持许多短路径。尽管这些不同的方法在网络拓扑结构和训练过程中有所不同,但它们都具有一个关键特征:它们创建了从前面层到后续层的短路径。

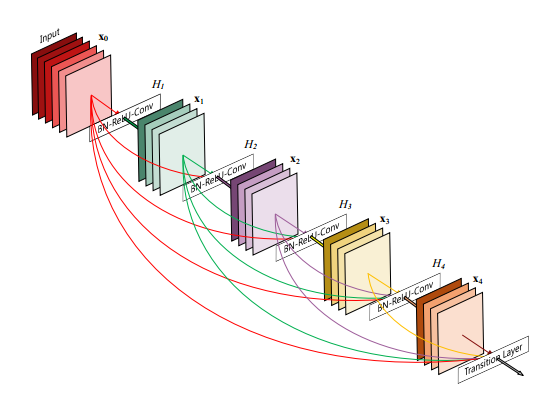

在本文中,我们提出了一种将这种方法提炼成简单连接模式的架构:为了确保网络中各层之间的最大信息流,我们直接将所有层(具有匹配的特征映射大小)连接起来。为了保留前向传播的特性,每个层从前面的所有层获得附加输入,并将其自身的特征映射传递到所有后续层。如图一所示。

Figure 1: A 5-layer dense block with a growth rate of k = 4. Each layer takes all preceding feature-maps as input.

图1:一个k = 4的增长率5层dense block。每层将所有前面的特征映射作为输入文章源自联网快讯-https://x1995.cn/3478.html

至关重要的是,与ResNets相比,我们没有采用合并之前所有层的特征到一层的方法,相反,我们把它们连接起来结合所有层的特点。因此,该ℓ层有ℓ个输入,由之前的所有卷积块的特征图组成,它自己的特征映射被传递到所有的L-ℓ后续层。这在L层网络中引入连接,而不像传统体系结构中的L那样。 由于其密集的连接模式,我们将我们的方法称为密集卷积网络(DenseNet)。一个可能这种密集的连接模式的直观效果是它需要的参数比传统的卷积网络少,无需重新学习冗余特征图。传统的前馈结构可以看作是一种状态的算法,它是从层到层传递的。每个层从其上一层读取状态并写入后续层,它改变了状态,但也传递了需要保存的信息。 ResNets [11]清楚地保存信息是通过附加的标识转换。ResNets [13]最近的改进表明,有很多层的贡献很少,实际上可以在训练期间随机丢弃,使得ResNet的状态类似于(展开的)递归神经网络[21],但是ResNets的参数数目要大得多,因为每一个层都有自己的权重。我们提出的DenseNet体系结构清楚的区分添加到网络的信息和保存的信息。DenseNet层很窄(例如,每层12个filter),添加少量的特征图的“集体知识”的网络,保持其余的特征图不变,最终的分类器的结果是基于网络的所有特征图。除了更好的参数效率之外,DenseNets的一大优势是改善了整个网络中的信息流和梯度,这使得它们易于训练。每一层都可以直接从损失函数和原始输入信号中获得梯度,从而产生隐含的深层监督[20]。这有助于深入网络体系结构的训练。 此外,我们还观察到密集连接具有正则化效应,缓解了训练集小导致的过拟合现象。

2. Related Work

网络架构的探索自从最初的发现以来一直是神经网络研究的一部分。 最近神经网络的流行再度兴起了这个研究领域。 现代网络中越来越多的层放大了架构之间的差异,并且激发了对不同连接模式的探索以及旧研究思路的重新审视。

类似于我们提出的密集网络布局的级联结构已经在20世纪80年代的神经网络文献中被研究[3]。他们的开创性工作主要集中在逐层训练的全连接的multi-layer上。 最近,提出了全连接的级联网络进行批梯度下降训练[39]。尽管对小数据集有效,但这种方法只能扩展到具有几百个参数的网络。 在[9,23,30,40]中,已经发现通过跳跃连接来利用CNN中的多级特征对于各种视觉任务是有效的。 在我们的研究工作的同时,[1]得出了一个与我们的跨层连接类似的网络的纯理论框架。

Highway Networks [33]是最早提出100层网络架构之一,它提供了一种有效的方式来训练超过100层的end-to-end网络。使用bypassing paths和门控单元,数百层的Highway Networks可以毫无困难地优化。bypassing paths(旁路路径)被认为是训练这些非常深网络的关键因素。ResNets [11]进一步支持这一点,其中纯身份映射被用作旁路路径。 ResNet在许多具有挑战性的图像识别,定位和检测任务(如ImageNet和COCO目标检测)方面取得了非常厉害的创纪录的性能[11]。最近,Stochastic depth成功训练了1202层ResNet [13]。 Stochastic depth通过在训练期间随机丢弃层来改善深度残留网络的训练。这表明并不是所有的层都是需要的,并且强调在深度(剩余)网络中存在大量的冗余。 我们的论文部分受到这一现象的启发。 具有pre-activation的ResNets也有助于训练1000多层最先进的网络[12]。

使网络更深的正交方法(例如,借助跳过连接)是增加网络宽度。GoogLeNet [35,36]使用一个“Inception module”,将不同大小的滤波器产生的特征图连接起来。 在[37]中,提出了具有广泛的广义残差块的ResNet的变体。事实上,只要增加每层ResNets中的滤波器数量,只要深度足够,就可以提高其性能[41]。FractalNets也使用广泛的网络结构在几个数据集上获得有竞争力的结果[17]。DenseNets不是从极其深层或广泛的体系结构中绘制代表性的力量,而是通过特性重用来挖掘网络的潜力,产生易于训练和具有高效的参数精简模型。把不同层学习的特征图连接起来会增加后续层输入的变化,并提高效率。这构成了DenseNets和ResNet之间的主要区别。 与Inception网络[35,36]相比,DenseNets更加简单和高效。还有其他引人注目的网络架构创新,已经取得了有竞争力的成果。NIN网络结构包括卷积层滤波器的多层感知器,用来提取更复杂的特征。DSN网络的内部层被辅助分类器直接监督的,它能够加强前面层接收的梯度。Ladder Networks (梯形网络)[26, 25]引入了自动编码器的横向连接,在半监督的学习任务中产生了非常高的精度。在[38]中,DFNS通过结合不同基础网络的中间层来提高信息流,增加具有最小化重建损失值性质的网络路径,可以改善图像分类模型。

3. DenseNets

考虑一张单一的图像x0通过一个卷积神经网络。这个网络有L层,每层实现一个非线性变换Hℓ(•),ℓ是层的编号,Hℓ(•)可以是批量归一化的复合函数(例如BN),rectified线性单元 (ReLU),池化或者卷积,Xℓ作为ℓ层的输出。

ResNets. 传统的卷积是把前馈网络ℓ层的输出作为(ℓ+ 1)层的输入[16],产生了如下的转换关系:Xℓ= H(Xℓ−1)。ResNets [11]添加一个跳过连接绕过非线性变换的特征函数:

xℓ = Hℓ(xℓ−1) + xℓ−1.

resnets的优点是梯度直接通过特征函数从后面层流向前面的层,然而,特征函数和Hℓ输出求和可能阻碍网络中的信息流。

Dense connectivity

为了进一步改善层之间的信息流,我们提出了不同的连接模式:我们引入了从任何层到所有后续层的直接连接。 图1示意性地示出了由此产生的DenseNet的布局。 因此,第ℓ层接收所有前面的层x0,…,Xℓ−1的特征图作为输入:

xℓ = Hℓ([x0,x1,…,xℓ−1]), (2)

其中[x0,x1,…,xℓ-1]是指在层0,…,ℓ-1中产生的特征图的拼接。 由于密集的连接性,我们把这种网络结构称为密集卷积网络(DenseNet)。Hℓ(•)的多输入在式(2)为一个张量。(这部分的意思是说,Hℓ的输入是前面0到ℓ-1个X特征图)

Composite function.

由[12]推导,我们定义H l(•)为三个连续操作的复合函数:批量归一化(BN)[14],其次是(ReLU)[6]和3×3卷积(Conv)

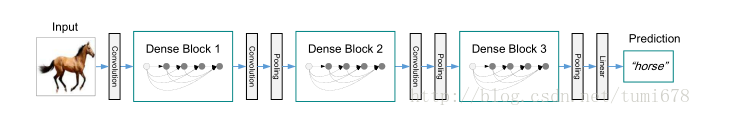

Figure 2: A deep DenseNet with three dense blocks. The layers between two adjacent blocks are referred

to as transition layers and change feature-map sizes via convolution and pooling.文章源自联网快讯-https://x1995.cn/3478.html

Pooling layers

方程(2)中使用的连接操作在特征图的大小改变时是不可行的。(个人理解是,第一步的dense connectivity,如果特征图的尺寸不一致,不能进行连接操作的) 然而,卷积网络的一个重要组成部分是下采样层,它改变了特征图的大小。 为了简化体系结构中的下采样,我们将网络划分为多个密集连接的密集块; 见图2。我们将块之间的层称为过渡层(transition layers),对它们做卷积和池化。 在我们的实验中使用的过渡层由batch normalization层和1×1卷积层,然后是2×2平均池化层组成。

Growth rate.

如果每个函数Hℓ产生k个 featuremaps,由此可见,ℓ层有K0 + K×(ℓ−1)输入特征图,其中K0是输入层的通道数(如果是初始的RGB,就是K0就是3)。DenseNet和现有的网络体系结构的一个重要的区别是,DenseNet可以有很窄的层,例如,K = 12。我们将超参数K作为网络的增长率。我们在第4节中提到,一个相对较小的增长率足以在我们测试的数据集上获得了最先进的结果。对此的一个解释是,每一层都可以访问其块中的所有前面的特征图,因此可以访问网络的“集体知识”。 可以将特征图视为网络的全局状态。 每个层都将自己的k个特征图添加到这个状态。 增长率规定了每个层对全局状态贡献的新信息量。 全局状态一旦写入,就可以从网络中的任何地方访问,与传统的网络体系结构不同的是,并不需要一层一层地复制它。

Bottleneck layers.

虽然每个层只输出k个特征图,但它通常有更多的输入。在[ 36, 11 ] 已经指出,1×1卷积可以作为Bottleneck layers在每3×3卷积来减少输入特征图的数量(这部分是降维),从而提高计算效率。我们发现这个设计对于DenseNet特别有效,我们把这个Bottleneck layers称为我们的网络,即对于H层的BN-ReLU-Conv(1×1)-BN-ReLU-Conv(3×3)版本,DenseNet-B。 在我们的实验中,我们让每个1×1卷积产生4k个特征图。

Compression.

为了进一步提高模型的紧凑性,我们可以减少过渡层的特征图数量。 如果一个密集块包含m个特征图,我们让下面的过渡层产生⌊θm⌋输出特征图,其中0 <θ≤1被称为压缩因子。 当θ= 1时,过渡层上的特征图的数量保持不变。 我们称DenseNet的θ<1为DenseNet-C,在实验中设定θ= 0.5。 当使用θ<1的瓶颈和过渡层时,我们将模型称为DenseNet-BC。

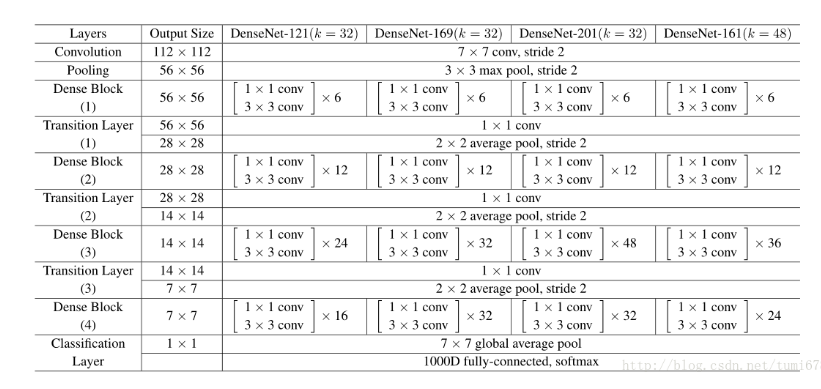

Table 1: DenseNet architectures for ImageNet. The growth rate for the first 3 networks is k = 32, and k = 48 for DenseNet-161. Note that each “conv” layer shown in the table corresponds the sequence BN-ReLU-Conv.

Implementation Details

在除ImageNet以外的所有数据集上,我们实验中使用的DenseNet有三个密集块,每个块都有相同数量的层。在进入第一密集块之前,对输入图像执行16(或DenseNet-BC增长率的两倍)输出通道的卷积。 对于卷积核大小为3×3的卷积层,输入的每一边都被填充一个像素以保持特征图大小的不变。我们使用1×1卷积,然后使用2×2平均池化作为两个连续密集块之间的过渡层。 在最后一个密集块的末尾,采用一个全局平均池化,然后附加一个softmax分类器。三个密集块中的特征图大小分别是32×32,16×16和8×8。 我们试验了配置分别为{L = 40,k = 12},{L = 100,k = 12}和{L = 100,k = 24}的基本DenseNet结构。对于DenseNetBC,评估配置为{L = 100,k = 12},{L = 250,k = 24}和{L = 190,k = 40}的网络。

在ImageNet的实验中,我们使用了DenseNet-BC结构,在224×224的输入图像上有4个密集块。 初始卷积层包括为步长为2的7×7卷积的2k个;所有其他层中的特征图的数量设置为k。我们在ImageNet上使用的确切网络配置如表1所示。

4.Experiments

我们的经验验证了DenseNet在几个标准数据集上的有效性,并与现有的ResNet及其变体架构进行了比较。

4.1Datasets

CIFAR。 两个CIFAR数据集[15]由32×32像素的彩色自然图像组成。 CIFAR-10(C10)由10个图像和100个类别的CIFAR-100(C100)组成。 训练和测试集合分别包含50,000和10,000个图像,并且我们有5000个训练图像作为验证集。我们采用广泛用于这两个数据集的标准数据增强方案(镜像/移位)[11,13,17,22,27,20,31,33]。 我们用数据集名称末尾的“+”标记(例如C10 +)表示采用的数据增强。对于预处理,我们使用the channel means 和 standard deviations对数据进行归一化处理。 为了最后的运行,我们使用所有50,000张训练图像,并在训练结束时报告最终的测试错误。

SVHN.

街景房屋号码(SVHN)数据集[24]包含32×32彩色数字图像。 训练集中有73,257幅图像,测试集中有26,032幅图像,531,131幅图像用于额外训练。按照惯例[7,13,20,22,29],我们使用所有的训练数据没有任何数据增强,并且从训练集中分离出具有6000个图像的验证集合。 我们选择训练期间验证错误最低的模型并报告测试错误。 我们遵循[41]并将像素值除以255,使其在[0,1]范围内。

ImageNet.

ILSVRC 2012分类数据集[2]包括来自1,000个类的120万个用于训练的图像和50,000个用于验证的图像。 我们采用与[8,11,12]中相同的数据增强方案来训练图像,并且在测试时应用尺寸为224×224的single-crop 或 10-crop 。 在[11,12,13]之后,我们在验证集上报告分类错误。

4.2Training

所有的网络都使用随机梯度下降(SGD)进行训练。 在CIFAR和SVHN上,我们用64 batch size 分别训练300和40轮。 最初的学习率设定为0.1,在训练时期总数中的50%和75%除以10。 在ImageNet上,采用batch size为256训练90轮。学习速率初始设置为0.1,在30和60轮时降低10倍。由于GPU内存的限制,我们最大的型号(DenseNet-161)以mini-batch size 128进行训练。为了弥补较小batch size,我们训练这个模型100轮,在90轮时采用除以10的学习率.

我们使用10-4的权重衰减和0.9的Nesterov动量[34],其中Nesterov动量不衰减。 我们采用由[10]引入的权重初始化。 对于没有数据增强的三个数据集,即C10,C100和SVHN,我们在每个卷积层(除了第一个卷积层)之后添加一个丢失层[32],并将丢失率设置为0.2。 测试错误仅针对每个任务和模型设置评估一次。

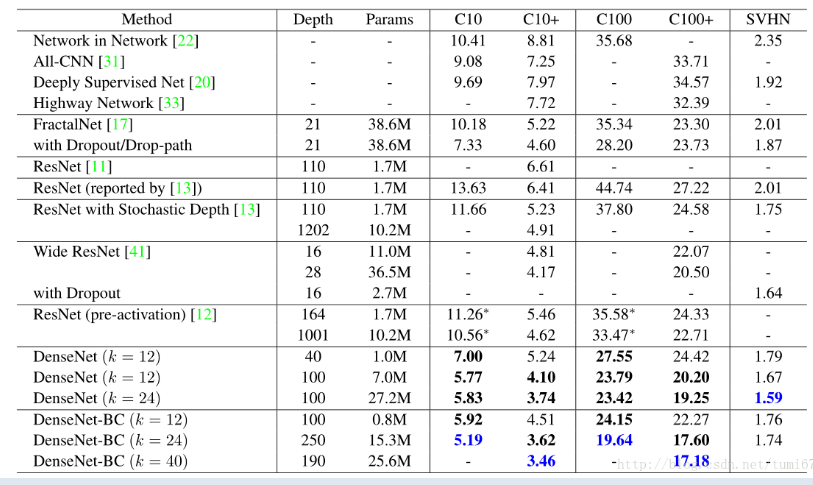

4.3Classification Results on CIFAR and SVHN

我们用不同的深度L和增长率k来训练DenseNets。 表2列出了CIFAR和SVHN的主要结果。为了突出总体趋势,我们将超过现有技术水平的以粗体显示,并以蓝色表示最好的结果。文章源自联网快讯-https://x1995.cn/3478.html

文章源自联网快讯-https://x1995.cn/3478.html

文章源自联网快讯-https://x1995.cn/3478.html

Accuracy.

可能最明显的趋势可能起源于表2的最后一行,这表明在所有CIFAR数据集上,具有L = 190和k = 40的DenseNet-BC一致地优于现有技术水平。 它在C10 +上的错误率为3.46%,在C100 +上的错误率为17.18%,明显低于ResNet架构[41]的错误率。我们在C10和C100上的最好结果(没有数据增加)更令人鼓舞:两者都比FractalNet低30%,并且具有下降路径正则化[17]。 在SVHN上,当丢失层时,L = 100和k = 24的DenseNet也超过了ResNet所取得的最好结果。 然而,250层的DenseNet-BC并没有进一步改善其性能。 这可以解释为SVHN是一个相对容易的任务,而且深的模型可能会产生过拟合现象。

Capacity.

在没有压缩或Bottleneck layers的情况下,随着L和k增加,DenseNets表现出更好的性能。 我们把这主要归因于模型能力的相应增长。 这最好由C10 +和C100 +列表示。 在C10 +上,随着参数从1.0M增加到7.0M,再增加到27.2M,误差从5.24%下降到4.10%,最终下降到3.74%。在C100 +上,我们观察到了类似的趋势。 这表明DenseNets可以利用越来越深的模型的代表性力量。 这也表明它们不会出现过拟合或残余网络的优化困难[11]。

Parameter Efficiency.

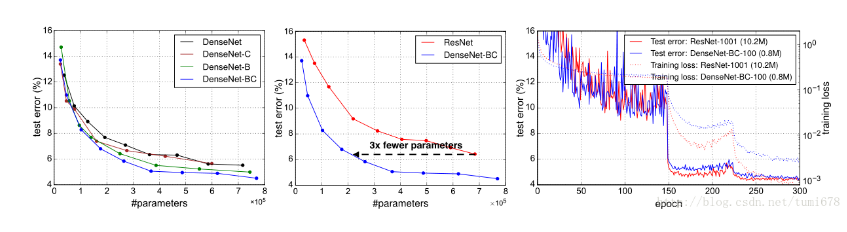

表2的结果表明,densenets利用参数比其他结构更有效(特别是resnets)。在过渡层的瓶颈结构和降维densenet BC特别有效。例如,我们的250层模型只有15.3M的参数,但它一直优于其他模型,如FractalNet和Wide ResNets有超过30M的参数。 我们还强调,L = 100和k = 12的DenseNet-BC(例如,C10 +上的4.51%比4.62%,C100 +上的22.27%比22.71%) 与1001层预激活ResNet使用90%参数的可达到同等的性能。图4(右图)显示了这两个网络在C10 +上的训练损失和测试误差。 1001层深的ResNet收敛到较低的训练损失值,但有类似的测试错误。 我们在下面进行更详细地分析。

Figure 4: Left: Comparison of the parameter efficiency on C10+ between DenseNet variations. Middle: Comparison of the parameter efficiency between DenseNet-BC and (pre-activation) ResNets. DenseNet-BC requires about 1/3 of the parameters as ResNet to achieve comparable accuracy. Right: Training and testing curves of the 1001-layer pre-activation ResNet [12] with more than 10M parameters and a 100-layer DenseNet with only 0.8M parameters.文章源自联网快讯-https://x1995.cn/3478.html

Overfitting.

更有效地使用参数的一个积极副作用是DenseNets不易过拟合。 我们观察到,在没有数据增强的数据集上,DenseNet体系结构相对于之前工作的改进尤其明显。 在C10上,这一改进使得错误率从7.33%降至5.19%,相对减少了29%。 在C100上,减幅从30%左右到28.20%再下降到19.64%。在我们的实验中,我们发现潜在的过拟合单一的设置:在C10,由增加k = 12到k = 24产生的参数的4倍增长导致误差从5.77%适度增加到5.83%。 DenseNet-BC bottleneck和压缩层似乎是对付这一趋势的有效方法。

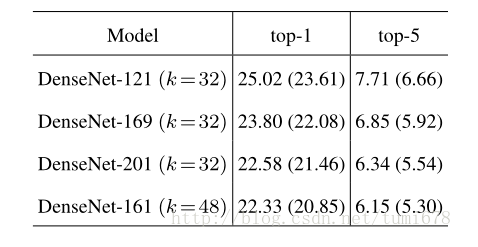

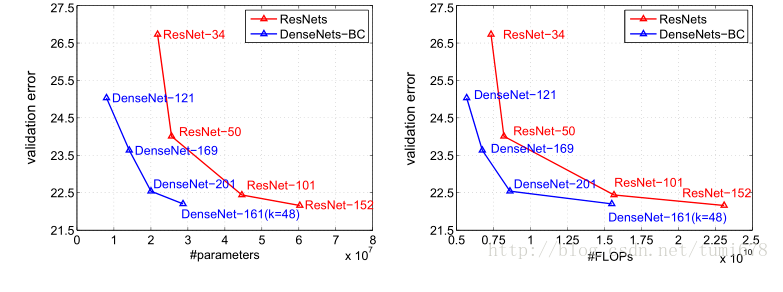

4.4 Classification Results on ImageNet

我们在ImageNet分类任务中评估不同深度和增长率的DenseNet-BC,并将其与最先进的ResNet体系结构进行比较。 为了确保两种架构之间的公平比较,我们消除了所有其他因素,如数据预处理和优化设置的差异,采用[8]的ResNet的公开Torch实现。我们只需用DenseNet-BC网络替换ResNet模型,并保持所有的实验设置与用于ResNet的设置完全相同。 唯一的例外是,由于GPU内存限制,我们最大的DenseNet模型采用mini-batch size为128来进行训练,在训练这个模型100轮,第90次学习率下降,以补偿较小的batch size。我们在表3中的ImageNet上报告了DenseNets的single-crop和10-crop验证错误。图3显示了DenseNets和ResNets的single-crop top-1验证错误作为参数数量(左)和FLOP(右)。图中显示的结果表明,DenseNets与最先进的ResNet相媲美,同时需要显着减少的参数和计算来实现比较好的性能。 例如,具有20M参数模型的DenseNet-201产生与具有超过40M参数的101层ResNet相似的验证误差。从右侧面可以观察到类似的趋势,它将验证误差绘制为FLOP数量的函数:一个DenseNet需要尽可能多的ResNet-50执行与ResNet-101相同的计算,这需要两倍计算。

值得注意的是,我们的实验设置意味着我们使用为优化的ResNets而不是DenseNets超参数设置。 可以想像,通过最多两个或三个过渡层提供对所有层的直接监督。然而,损失函数和梯度densenets基本上不太复杂,因为同样的损失函数是各层之间共享。可以想象,更广泛的超参数搜索可以进一步提高ImageNet上DenseNet的性能。

5.Discussion

从表面上看,DenseNets和ResNet非常相似:Eq.(2)与式(1)只在Hℓ输入(•)连接起来而不是加和。 然而,这个看起来很小的修改的影响导致两个网络架构的本质大不相同。

Model compactness.

输入连接的直接结果是,由任何DenseNet层学习的特征图可以被所有后续层访问。 这使得整个网络的功能重用,并使模型更紧凑。图4中的左边两张图显示实验的结果,该实验的目的是比较所有DenseNets变体的参数效率(左)以及同等的ResNet架构(中)。 我们在C10 +上训练多个不同深度的小网络,并将他们的测试精度绘制成网络参数的函数。 与其他流行的网络体系结构(如AlexNet [16]或VGG-net [28])相比,具有预激活功能的ResNets使用更少的参数,却通常会取得更好的结果[12]。 因此,我们比较DenseNet(k = 12)与这个架构。 DenseNet的训练设置与上一节保持一致。

该图显示DenseNet-BC始终是DenseNet的最多参数有效变体。 此外,为了达到相同的准确度,DenseNet-BC只需要ResNets(中间图)的大约1/3的参数。 这个结果与我们在图3中给出的ImageNet的结果是一致的。图4中的右图显示了只有0.8M可训练参数的DenseNet-BC能够达到与1001层(预激活) ResNet [12]有10.2M参数。

Implicit Deep Supervision.

对密集卷积网络的改进精确度的一个解释可能是单个层通过较短的连接从损失函数接收额外的监督。 人们可以解释DenseNets进行一种“深度监督”。 深度监督的好处之前已经在深度监督的网络(DSN; [20])中显示出来,它们在每一个隐藏层都附加了分类器,加强中间层学习判别特征。DenseNets以隐式方式执行类似的深度监督:网络顶部的单个分类器通过至多两个或三个过渡层提供对所有层的直接监督。 然而,DenseNets的损失函数和梯度要复杂得多,因为所有层之间共享相同的损失函数。

Stochastic vs. deterministic connection.

密集卷积网络与残差网络的随机深度正则化之间存在着一个有趣的联系[13]。 在随机深度中,剩余网络中的层随机丢弃,这会在周围层之间建立直接连接。 由于池层永远不会丢失,因此网络会产生与DenseNet相似的连接模式:如果所有中间层都是随机丢弃的,则在相同池层之间的任何两层之间有一个小概率被直接连接。 尽管这些方法最终是完全不同的,但DenseNet对随机深度的解释可能为正规化的成功提供了见解。

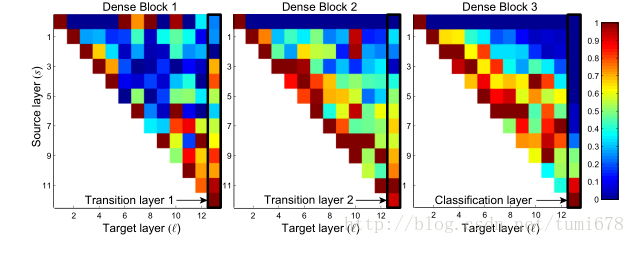

Feature Reuse

通过设计,DenseNets允许层访问来自其所有先前层的特征图(尽管有时通过过渡层)。 我们进行一项实验来调查一个训练有素的网络是否利用这个机会。 我们首先在C10 +上训练一个DenseNet,L = 40和k = 12。每个卷积层ℓ块内,我们计算分配给层s的连接的平均(绝对)权重。图5显示了所有三个密集块的热图。 平均绝对权重用作卷积层在其前面层上的依赖性的替代物。 位置(ℓ,s)上的红点表示层ℓ,平均使用之前产生的s层的特征图。 可以从图中得到几个观察结果:文章源自联网快讯-https://x1995.cn/3478.html

Figure 5: The average absolute filter weights of convolutional layers in a trained DenseNet. The color of pixel (s,ℓ) encodes the average L1 norm (normalized by number of input feature-maps) of the weights connecting convolutional layer s to ℓ within a dense block. Three columns highlighted by black rectangles correspond to two transition layers and the classification layer. The first row encodes weights connected to the input layer of the dense block.文章源自联网快讯-https://x1995.cn/3478.html

1所有层在同一个块内的许多输入上分布权重。 这表明,非常早期层提取的特征实际上直接被整个同一密集块中的深层使用。

2.过渡层的权重也将它们的权重分布在前一个密集块内的所有层上,这表明DenseNet从第一层到最后一层的信息流通过几乎没有间接传递。

3.第二和第三密集块内的层一致地将最小权重分配给过渡层的输出(三角形的顶部行),表明过渡层输出许多冗余特征(平均具有低权重)。 这与DenseNet-BC的强大结果保持一致,在这些结果中,这些输出被压缩。

4.虽然右边显示的最后一个分类层也使用整个密集块的权重,但似乎更专注最后的特征图,它表明在网络后面层可能会产生更多的高级特征。

6.Conclusion

我们提出了一种新的卷积网络体系结构,我们称之为密集卷积网络(DenseNet)。 它引入具有相同特征图大小的任何两个层之间的直接连接。 我们发现DenseNets可以自然地扩展到数百层,同时不会出现优化困难。在我们的实验中,DenseNets随着参数数量的增加精度也随之提高,而没有任何性能下降或过拟合的现象。 在多种设置下,它在几个常用数据集上实现了最先进的结果。 而且,DenseNets采用更少的参数和更少的计算来实现最先进的性能。因为我们在本研究中采用了针对残差网络优化的超参数设置,所以我们相信通过更详细地调整超参数和学习率,可以使DenseNets准确度的进一步提高。

DenseNets遵循一个简单的连接规则,自然而然地结合了恒等映射,深度监督和深度多样化。它们允许在整个网络中重用特征,因此它们可以学习更紧凑,并且在我们的实验结果中更精确的模型。因为DenseNets内部表示紧凑,特征冗余较少,所以可以很好地进行各种基于卷积特征的计算机视觉任务的特征提取,例如[4,5]。 我们计划在未来的工作中研究DenseNets的这种特征变换。文章源自联网快讯-https://x1995.cn/3478.html

评论